À propos d’un livre de Serge Tisseron et d’une idée reçue tenace sur l’IA

Mémoire, image, intelligence artificielle : ce que j’ai retenu du livre de Serge Tisseron, suivi d’un éclairage sur un malentendu persistant autour de la création d’images par IA.

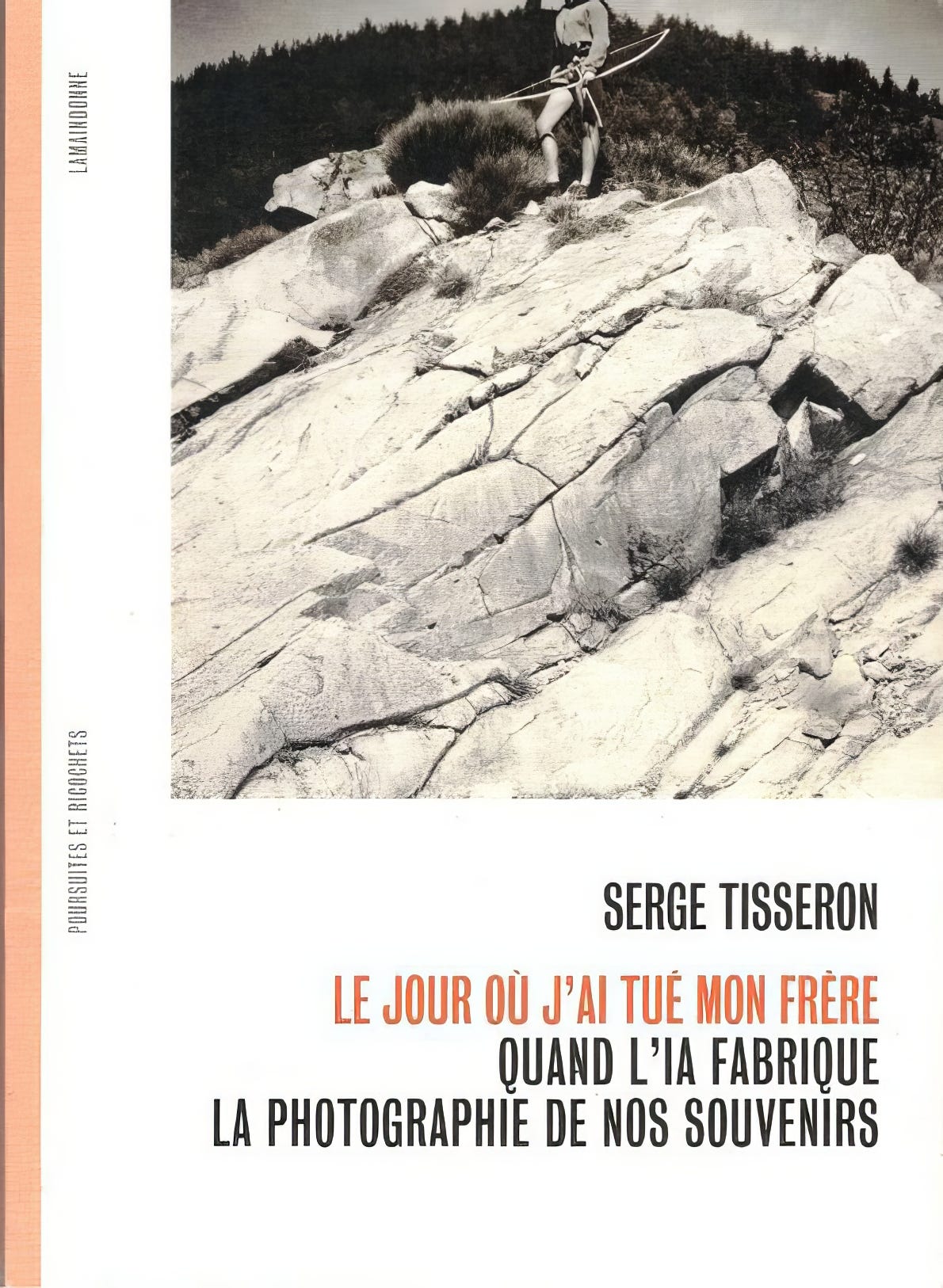

Partie 1 - Le Livre de Serge Tisseron « Le jour où j’ai tué mon frère - quand l’IA fabrique la photographie de nos souvenirs »

1. Qui est Serge Tisseron

Serge Tisseron est psychiatre, psychanalyste et docteur en psychologie. Membre de l’Académie des technologies et du Conseil national du numérique, il consacre l’essentiel de son travail à la relation que nous entretenons avec les images, les secrets de famille et les nouvelles technologies. Il s’est fait connaître dans les années 1980 en identifiant, à partir de la seule lecture des albums de Tintin, un secret familial chez Hergé, intuition confirmée des années plus tard par ses biographes. Il a été l’un des premiers en France à explorer les effets pathogènes des secrets transgénérationnels, mais aussi à penser l’impact psychique de la télévision, des jeux vidéo, puis des robots et mondes numériques. Il a publié plus de quarante essais personnels, dont La honte, Secrets de famille, mode d’emploi, Psychanalyse de l’image ou encore Le jour où mon robot m’aimera. Il a également travaillé sur la photographie, à la fois comme commissaire d’exposition et comme théoricien. Aujourd’hui, il s’intéresse de près à l’intelligence artificielle et à ses effets sur la mémoire.

2. Résumé du livre

Dans Le jour où j’ai tué mon frère, Serge Tisseron part d’un souvenir d’enfance: une scène de jeu avec son frère, dans les années 1960, qu’il est persuadé d’avoir vue en photo. Il se souvient d’un duel fictif, d’une victoire symbolique, et d’un cliché pris par leur père. Mais lorsqu’il consulte l’album familial, la photo est absente. Il tente alors de la retrouver, d’abord en la dessinant, puis en la générant avec différents outils d’intelligence artificielle.

Ce geste devient le point de départ d’une réflexion plus large sur la mémoire, le pouvoir des images, et la manière dont l’IA transforme notre rapport au passé. L’expérience décrite est ambivalente : à la fois fascinante et troublante. L’image générée ne correspond pas exactement au souvenir, mais elle finit par s’imposer. Elle risque de remplacer le flou vivant de la mémoire par une image figée, partiellement inexacte, mais visuellement convaincante.

Reconnaissant ce trouble, Tisseron développe une critique nette de l’IA. Pour lui, celle-ci « ne fait que copier » : elle chercherait dans des bases de données, appliquerait des modèles, mais sans créativité ni subjectivité. Elle fonctionnerait comme un dispositif de reproduction, sans véritable capacité de transformation.

Le livre mêle récit personnel, références psychanalytiques, et métaphores quantiques (notamment le chat de Schrödinger) pour penser les paradoxes du souvenir. Il s’achève sur une vision à la fois poétique et prudente : celle d’un monde où chacun pourrait recomposer les images manquantes de sa vie, non pour travestir le réel, mais pour mieux le transmettre, tout en appelant à la vigilance face aux usages possibles de ces images.

3. Ce avec quoi je suis d’accord (et ce que je nuance)

Le point fort du livre de Serge Tisseron, à mes yeux, c’est son intuition sur la mémoire. Il rappelle que notre mémoire est incertaine, partielle, en perpétuelle reconstruction, et que les images générées par l’IA viennent épouser exactement cette logique. Sur ce point, je le rejoins entièrement. Ce n’est pas une idée théorique pour moi : c’est une réalité vécue, observée dans mes ateliers. J’ai vu ce moment où une personne regarde une image générée à partir d’un souvenir, et dit que cela lui suffit. Non parce que l’image est fidèle dans le détail, mais parce qu’elle exprime l’essentiel. Parce qu’elle touche juste.

Mais là où je m’éloigne de son analyse, c’est dans la peur que l’IA puisse « réécrire » nos souvenirs. Cette inquiétude me semble mal orientée. Une image générée par une IA ne fait que refléter ce qu’on lui donne : si la mémoire est confuse, l’image le sera aussi. L’IA ne trahit rien, elle ne fait que rendre visible une incertitude déjà présente. La vraie question, alors, n’est pas celle de la fidélité, mais celle de l’acceptation de cette fidélité impossible.

À mon sens, cette peur vient d’un biais générationnel. Pour ceux qui ont grandi avec l’idée que la photographie documente fidèlement le réel, voir apparaître une « fausse » photo peut être troublant. Mais les plus jeunes, eux, n’ont jamais cru à la photographie comme garantie de vérité. Ils vivent déjà dans un monde d’images malléables, composites, filtrées, remixées. Imaginer que ces nouvelles images générées vont remplacer les photos de famille, c’est attribuer à la photo une autorité qu’elle n’a plus.

Et d’ailleurs, si Serge Tisseron avait demandé à un peintre de représenter un souvenir, il n’aurait probablement pas ressenti ce même trouble. Ce qui l’inquiète ici, ce n’est pas l’image en tant que telle, mais le fait qu’elle emprunte les codes visuels de la photographie. Or ce rapport à la réalité supposée de la photo a toujours été une construction fragile, et la manipulation des images n’est pas née avec l’intelligence artificielle. Ce qui change, c’est l’échelle et l’intimité de l’acte créatif, rendu accessible à chacun.

Partie 2 - La machine à voler et copier

1. Un malentendu massif sur la création d’images

Au fil des interventions que j’ai pu faire, dans des collèges, des lycées, ou auprès d’artistes, j’ai pris l’habitude de poser une question simple aux participants : « D’après vous, comment fonctionne une IA qui génère des images ? » La réponse, presque toujours, est la même. Et c’est là que j’ai compris l’ampleur du malentendu.

Une fois, au bout d’une heure d’intervention dans un lycée, une jeune femme m’a dit : « Je vais peut-être poser une question bête… mais est-ce que la machine crée des images ? » J’ai répondu : « Bien sûr que oui. C’est même pour vous présenter ce service qui crée des images que je suis venu ici. » Je me suis alors rendu compte que ce n’était pas du tout évident pour elle. Malgré ma présentation, l’idée même qu’on puisse créer une image à partir de rien n’avait pas été intégrée. Et j’ai été très frappé, parce que je n’arrivais pas à comprendre comment on pouvait penser autre chose.

Une autre fois, lors d’un atelier avec un petit groupe de jeunes, on leur a donné accès à MidJourney. Très vite, les filles ont commencé à taper des mots, à s’amuser avec l’interface. Et je me suis rendu compte qu’elles pensaient que c’était un moteur de recherche. Je leur ai dit : « Ce n’est pas un moteur de recherche, ça crée des images. » Mais à ma grande surprise, elles ne m’ont pas cru. Elles ont cru que je plaisantais. Pour elles, c’était évident que ces images venaient d’ailleurs, qu’elles existaient déjà. Et il faut dire que la vitesse à laquelle MidJourney génère aujourd’hui rend ce malentendu tout à fait compréhensible. Je n’y avais jamais réfléchi avant. Alors, pour les convaincre, je leur ai proposé de générer une image impossible à trouver sur Internet, et je leur ai montré, en direct, que c’était bien une création née sur le moment.

Au fur et à mesure de mes interventions, et après ce que j’ai lu sur Internet en débattant avec des gens qui ne veulent pas en démordre, j’ai fini par comprendre la façon dont les gens pensent que ça fonctionne.

2. Le modèle mental le plus courant

Voici ce que j’ai découvert que la plupart des gens imaginent quand ils pensent à une IA générative d’images :

L’IA va sur Internet et enregistre des images. Elle les vole, les copie sans demander d’autorisation, et les stocke dans d’immenses banques de données sur ses serveurs.

Quand l’utilisateur tape un prompt, le logiciel agit comme un moteur de recherche. Il va chercher les images qui correspondent le mieux à la demande, et fait un habile collage à partir du matériau qu’il a trouvé sur ses serveurs.

C’est une vision simple, très intuitive, presque logique, mais elle est complètement fausse. Et tant qu’on reste prisonnier de ce schéma, on ne peut pas comprendre ce que ces outils changent vraiment dans notre rapport aux images.

3. Ce que l’IA fait réellement, version simple

Une IA générative ne vole pas des images et ne fait pas de collages. Elle fonctionne en deux étapes très différentes de ce que l’on imagine souvent.

L'entraînement : On lui a donné des millions d’images, accompagnées de mots ou de phrases. Elle les a analysées pour repérer des correspondances très fines entre les formes visuelles et les mots. Elle n’a pas conservé ces images, elle en a tiré des statistiques : une sorte de connaissance floue mais puissante. Elle a appris, elle n’a rien volé, comme un étudiant qui va au Louvre étudier mais ressort sans les tableaux.

La génération : Quand on lui demande une image, elle ne va rien chercher dans une base. Elle part d’un bruit aléatoire, comme un écran de neige numérique, et elle le transforme progressivement en image. Ce processus n’est pas une recherche, c’est une création. L’image qui en sort n’existait nulle part auparavant.

4. Ce que l’IA fait réellement, version technique

Les IA génératives d’images comme MidJourney, DALL·E ou Stable Diffusion ne stockent pas d’images. Elles n’en copient aucune. Leur fonctionnement repose sur deux grandes phases, toutes deux issues du deep learning : l'entraînement, puis l'inférence, c’est-à-dire la génération.

L'entraînement. L’IA est d’abord entraînée par apprentissage supervisé sur plusieurs centaines de millions d’images, chacune accompagnée de légendes ou de mots-clés. Ces images sont analysées par un réseau de neurones profonds (deep neural network), souvent du type transformer. L’IA n’enregistre pas les images : elle en extrait des corrélations statistiques, qu’elle encode sous forme de poids mathématiques. Ce qu’elle apprend, c’est un ensemble de régularités visuelles associées à du langage, pas des souvenirs d’images.

La génération. Lorsqu’on entre un prompt, l’IA ne cherche rien : elle génère une image depuis zéro. Elle part d’un bruit aléatoire (une sorte de nuage de pixels sans forme), et utilise un modèle de diffusion pour le transformer, étape par étape, en une image cohérente. Ce processus s’effectue dans ce qu’on appelle un espace latent, une représentation mathématique intermédiaire. À chaque étape, l’IA débruite ce signal en se basant sur les associations apprises, jusqu’à obtenir une image unique, entièrement calculée, jamais vue auparavant.

En résumé : l’IA ne copie pas, ne recherche pas, ne colle rien. Elle recompose à partir de probabilités, en générant une image entièrement neuve.

Pourquoi ces précisions comptent

Pourquoi insister sur ces détails techniques ? Pourquoi prendre la peine de corriger une idée fausse, même largement partagée ? Parce que ce n’est pas un point secondaire. Une grande part des craintes et des jugements éthiques portés aujourd’hui sur l’intelligence artificielle repose sur cette confusion.

Il faut être clair : les générateurs d’images ne volent pas. Ils n’assemblent pas des morceaux de photos existantes. Ils ne reproduisent pas des œuvres présentes sur Internet. Aux États-Unis, où la plupart de ces modèles ont été conçus, leur entraînement repose sur le principe du fair use, un usage transformateur, toléré à des fins d’analyse ou d’apprentissage. Il ne s’agit pas d’un vol, mais d’une opération statistique.

Cela ne signifie pas pour autant que tout est éthique par défaut. Mais si l’on souhaite poser les bonnes questions sur la mémoire, la création ou le rapport à la vérité, encore faut-il partir des faits. Tant qu’on reste prisonnier de l’image d’une photocopieuse algorithmique, le débat reste bloqué à sa surface.

Qu’en est-il alors du droit d’auteur ? Pourquoi cette impression persistante qu’il y aurait eu transgression ? Parce qu’il y a un véritable flou, non dans la technique, mais dans les cadres juridiques et symboliques qui l’encadrent. Le droit d’auteur a été conçu pour un monde matériel et la distribution physique. Il s’est vu bousculé par la dématérialisation d’Internet. Il est aujourd’hui mis à l’épreuve par l’IA.

Ce qui est vrai, et il faut le reconnaître, c’est que les chercheurs ont entraîné leurs modèles sur des millions d’images accessibles en ligne, sans demander l’autorisation des auteurs. Ils l’ont fait dans un cadre légal qui le permettait, en s’appuyant sur une interprétation du fair use. Et ils l’ont fait parce qu’il était tout simplement impossible d’agir autrement. S’ils avaient dû demander chaque autorisation, ces modèles n’existeraient pas.

Cela peut poser des questions morales. Mais il est indispensable de distinguer entre une analyse critique fondée sur les faits et une réaction émotionnelle nourrie de représentations erronées. La discussion éthique ne peut monter en qualité qu’à cette condition.

Conclusion

Je recommande la lecture du livre de Serge Tisseron. Il a le mérite rare, dans le paysage intellectuel français, d’entrer en contact direct avec l’IA, de tester, de raconter, d’interroger. Sa réflexion sur la mémoire est fine, sensible, souvent juste, même si je ne partage pas toutes ses craintes. C’est précisément cette crainte, largement répandue, que j’ai voulu éclairer ici.

Je ne suis pas chercheur en IA, mais je travaille avec ces outils, je les teste, je les interroge. Si j’ai dit une imprécision, je suis ouvert à la discussion. L’important, c’est de poser les bonnes questions.

Ce texte est aussi un appel à l’éducation. Le fossé entre ce que ces outils permettent aujourd’hui, et l’attitude de l’Éducation Nationale, devient chaque jour plus problématique. Interdire ou ignorer ne suffira pas. Il faut apprendre, transmettre, expérimenter. Faire venir des intervenants. Créer des espaces de discussion. Il vaut mieux que ce soit imparfait que pas fait du tout.

Enfin, les ateliers dont je parlais touchent à leur fin. J’y ai pris des notes tout au long du processus. Très bientôt, je partagerai un texte dédié à cette expérience : ce que l’IA permet, ce qu’elle transforme, et ce qu’elle révèle, notamment sur la mémoire, l’image, et ce que les deux peuvent encore inventer ensemble.